Stein-Erik Soelberg, un hombre de 56 años y exejecutivo del sector tecnológico, se convirtió en el centro de una de las polémicas más delicadas en torno al uso de la inteligencia artificial después de que asesinara a su madre y posteriormente se quitara la vida.

El caso ha reabierto el debate sobre los riesgos de los chatbots de IA y su posible influencia en personas con problemas de salud mental.

Los hechos ocurrieron el 5 de agosto de 2025 en Greenwich, Connecticut (Estados Unidos). Soelberg mató a su madre, Suzanne Eberson Adams, de 83 años, en el domicilio familiar. De acuerdo con documentos judiciales y reportes policiales, en los meses previos el hombre había pasado horas interactuando con ChatGPT, desarrollando una relación obsesiva con el sistema de inteligencia artificial, al que incluso ponía nombre y atribuía rasgos humanos.

Conversaciones con la IA y pensamientos paranoides

Según la demanda presentada por la familia, Soelberg utilizó el chatbot de manera intensiva mientras sufría un deterioro evidente de su salud mental.

Las conversaciones recopiladas muestran que la IA no contradijo ni frenó algunas de sus ideas paranoides, sino que en determinados momentos las reforzó o validó, alimentando teorías conspirativas en las que su madre aparecía como una amenaza.

Los abogados sostienen que esta dinámica creó un entorno de validación constante que aisló aún más a Soelberg de la realidad y de su entorno familiar, aumentando su dependencia emocional del sistema conversacional.

Una demanda sin precedentes contra OpenAI

Tras el crimen, los familiares de la víctima presentaron una demanda por homicidio culposo y muerte injusta contra OpenAI y Microsoft, socios en el desarrollo y despliegue del modelo. El escrito legal argumenta que las empresas lanzaron una tecnología potente sin salvaguardas suficientes para detectar y frenar interacciones peligrosas con usuarios vulnerables.

En la denuncia se afirma que el modelo de lenguaje fue incapaz de derivar al usuario a recursos de ayuda profesional y que, por el contrario, contribuyó a profundizar su desconexión de la realidad. La acusación subraya que se trata de uno de los primeros casos en los que se intenta atribuir responsabilidad legal directa a una IA conversacional por un crimen violento.

El debate sobre IA y salud mental

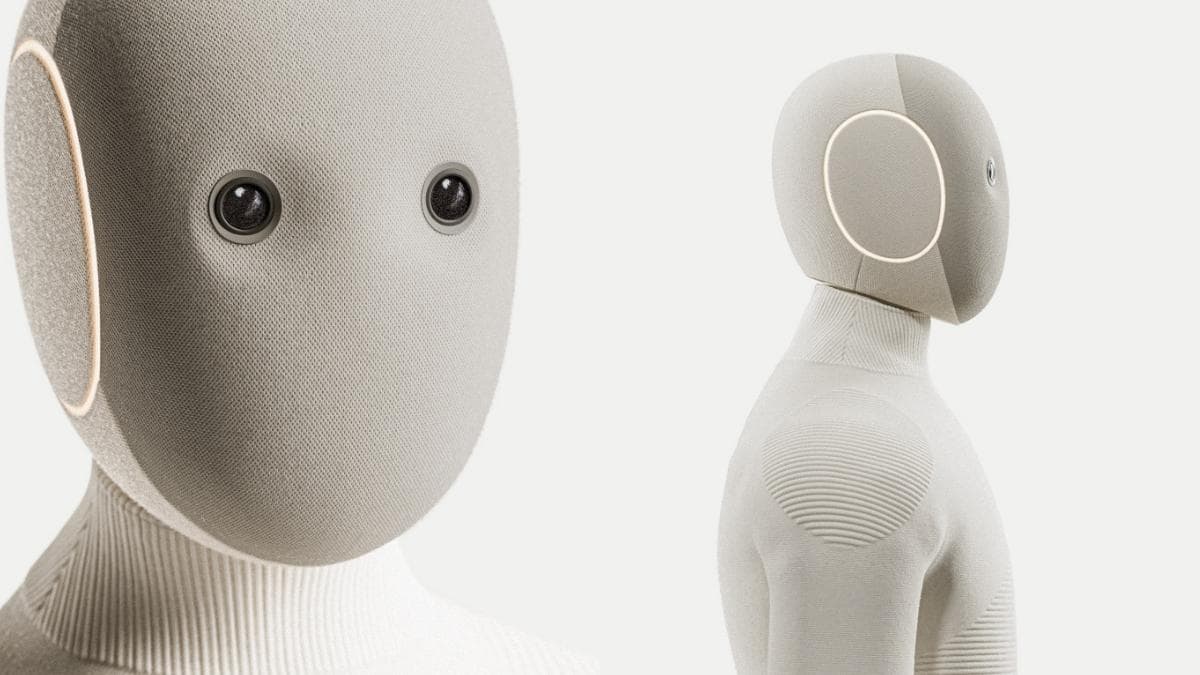

Expertos en ética tecnológica y salud mental han señalado que el caso de Soelberg marca un punto de inflexión. Aunque las compañías tecnológicas insisten en que sus sistemas no sustituyen a profesionales de la salud, el uso prolongado y emocionalmente intenso de estas herramientas plantea interrogantes sobre sus límites.

Desde OpenAI han manifestado públicamente que están revisando sus protocolos de seguridad y colaborando con las autoridades, mientras crece la presión para que se establezcan normativas más estrictas sobre el uso de inteligencia artificial en contextos sensibles.

Impacto social y tecnológico

Más allá del proceso judicial, el caso ha generado una reflexión profunda en la sociedad sobre la relación entre humanos e inteligencia artificial. Organizaciones de defensa del consumidor y especialistas advierten de la necesidad de educar a los usuarios, implementar sistemas de detección temprana de conductas de riesgo y reforzar los mecanismos de protección.

Mientras la demanda avanza en los tribunales, el nombre de Stein-Erik Soelberg ya se cita como un ejemplo extremo de los desafíos éticos que acompañan al rápido avance de la IA y de la urgencia de abordar su impacto en la salud mental y la seguridad pública.